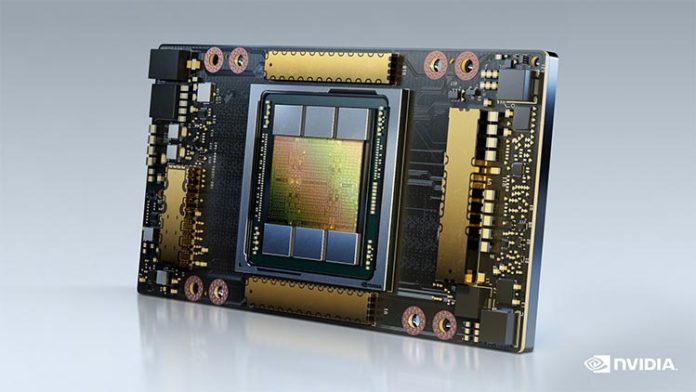

NVIDA ha superado la marca de ancho de banda de memoria de 2 terabytes por segundo con su nueva GPU, según anunció el gigante gráfico de Santa Clara. Se espera que la GPU NVIDIA A100 de 80 GB de primera línea se integre en múltiples configuraciones de GPU en sistemas durante la primera mitad de 2021.

A principios de este año, NVIDIA presentó el A100 con arquitectura Ampere, afirmando que la GPU proporcionó «el mayor salto en rendimiento» en su línea de hardware de gráficos. La firma aseguró que el entrenamiento de IA en la GPU podría ver aumentos de rendimiento de 20 veces la velocidad de sus unidades de generación anterior.

El nuevo modelo NVIDIA A100 de 80 GB ahora duplica la memoria de alto ancho de banda de 40 GB a 80 GB y aumenta la velocidad del ancho de banda de la matriz general en 0,4 TB por segundo, de 1,6 TB/s a 2 TB/s. Cuenta con una frecuencia de impulso de 1,41 GHz, bus de memoria de 5120 bits, 19,5 TFLOPS de rendimiento de precisión simple y 9,7 TFLOPS de rendimiento de doble precisión.

«Lograr resultados de vanguardia en la investigación de HPC e IA requiere la construcción de los modelos más grandes, pero estos exigen más capacidad de memoria y ancho de banda que nunca«, afirma Bryan Catanzaro, vicepresidente de investigación de aprendizaje profundo aplicado de NVIDIA. «La GPU A100 de 80 GB proporciona el doble de memoria que su predecesora, que se introdujo hace apenas seis meses, y rompe la barrera de los 2 TB por segundo, lo que permite a los investigadores abordar los desafíos científicos y de big data más importantes del mundo«.

Según Satoshi Matsuoka, director del RIKEN Center for Computational Science, «NVIDIA A100 con 80 GB de memoria GPU HBM2e, que proporciona el ancho de banda de 2 TB por segundo más rápido del mundo, ayudará a ofrecer un gran impulso en el rendimiento de aplicaciones«.

«Rendimiento de centro de datos sin un centro de datos»

La GPU será buscada por empresas dedicadas al análisis intensivo de datos, la renderización informática basada en la nube y la investigación científica como, por ejemplo, la previsión meteorológica, la química cuántica y el modelado de proteínas.

BMW, Lockheed Martin, NTT Docomo y el Pacific Northwest Laboratory están utilizando actualmente las estaciones DGX de NVIDIA para proyectos de IA.

NVIDIA proporcionó resultados de rendimiento en una serie de pruebas comparativas. La GPU logró triplicar el rendimiento en el aprendizaje profundo de inteligencia artificial y duplicar la velocidad en el análisis de big data.

Se espera que Atos, Dell Technologies, Fujitsu, Hewlett-Packard Enterprise, Lenovo, Quanta y Supermicro ofrezcan sistemas que utilicen placas base HGX A100 con configuraciones de cuatro u ocho GPU.

NVIDIA afirma que la nueva GPU ofrece «rendimiento de centro de datos sin un centro de datos«. Los clientes que buscan GPU A1000 individuales en una tarjeta PCIe están limitados a la versión VRAM de 40 GB únicamente, al menos por el momento.

NVIDA aún no ha anunciado los precios de esta versión. El DGX A100 original presentado la primavera pasada tenía un precio de 199.000 dólares.

Fuente: NVIDIA.